El reverse proxy con NGINX es una solución fundamental para empresas de telecomunicaciones, gobierno, banca y retail que buscan optimizar, asegurar y escalar su infraestructura web, gracias a la protección contra ataques, la mejora del rendimiento mediante caché y balanceo de carga, capacidades que son esenciales en el panorama digital actual.

¿Qué es un servidor Proxy inverso?

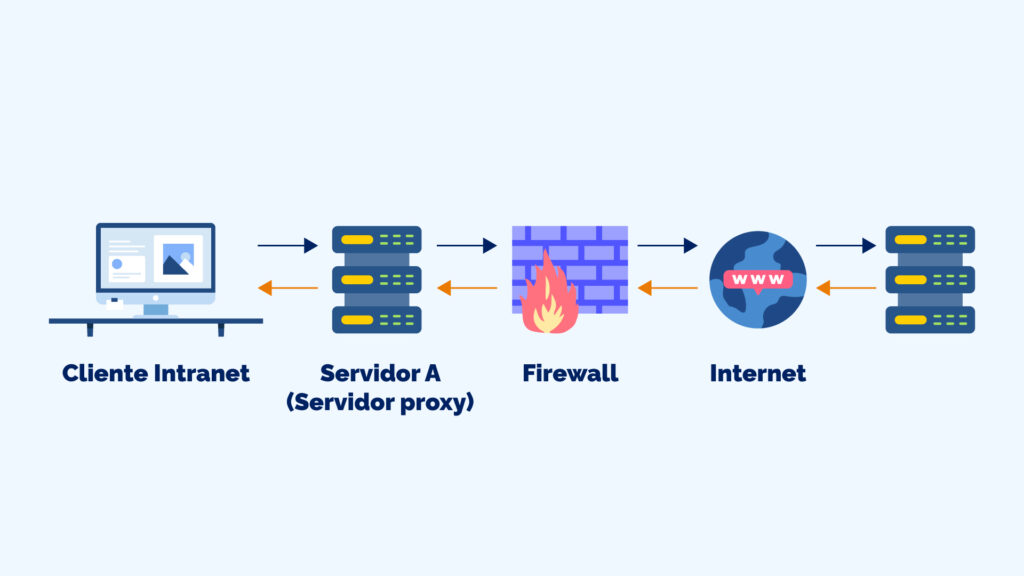

Un proxy inverso o reverse proxy es un servidor que actúa como puente entre los clientes (usuarios) y los servidores backend. A diferencia de un servidor tradicional que protege la identidad del cliente, el proxy inverso protege y optimiza los servidores de origen. Cuando un usuario realiza una solicitud HTTP, esta llega primero al servidor proxy inverso, que luego la reenvía al servidor apropiado y devuelve la respuesta al cliente.

Esta arquitectura es valiosa para quienes manejan un alto volumen de tráfico, pues actúa como un escudo protector y optimizador de rendimiento, elementos críticos en la transformación digital que empresas como Whitestack impulsan en América Latina.

¿Cómo funciona un Proxy inverso?

El funcionamiento de un servidor proxy inverso se basa en un proceso de intermediación inteligente. Cuando un cliente realiza una petición HTTP, el flujo es el siguiente:

- Recepción de la solicitud: El cliente envía su petición al reverse proxy, sin saber que está comunicándose con un intermediario

- Evaluación y procesamiento: El proxy inverso analiza la solicitud, aplica reglas de seguridad y determina el servidor backend más apropiado

- Reenvío al servidor origen: La solicitud se transmite al servidor seleccionado dentro de la red interna

- Respuesta al cliente: El servidor backend procesa la petición y envía la respuesta al proxy inverso, que la retransmite al cliente

Este proceso ocurre de manera transparente para el usuario final, quien percibe estar comunicándose directamente con el servidor de aplicaciones. Para sectores como la banca y el gobierno, donde la seguridad y el cumplimiento regulatorio son prioritarios, esta capa adicional de abstracción proporciona control y protección invaluables.

Beneficios de implementar un Reverse Pro

Mejora en la seguridad

El proxy inverso nginx ofrece múltiples capas de seguridad que son esenciales en entornos empresariales críticos. Al ocultar la estructura interna de los servidores, es posible reducir los intentos de ataque directo. Además, permite implementar políticas de seguridad centralizadas, filtrado de contenido malicioso y protección contra ataques DDoS.

Para instituciones financieras que enfrentan amenazas de ciberseguridad crecientes, esto representa una barrera fundamental contra intentos de intrusión, ya que el proxy inverso puede detectar y bloquear patrones de tráfico sospechosos antes de que alcancen los servidores de aplicación.

Optimización del rendimiento

Un nginx reverse proxy permite utilizar técnicas avanzadas de caché que reducen la carga en los servidores backend. Cuando múltiples usuarios solicitan el mismo contenido estático, puede servir estas respuestas desde su caché local, mejorando los tiempos de respuesta y reduciendo el ancho de banda necesario.

El caché proxy inverso NGINX puede marcar la diferencia entre un sitio que responde ágilmente y uno que colapsa bajo presión, optimización valiosa para empresas con altos picos de tráfico durante temporadas de alta demanda.

Balanceo de carga inteligente

El balanceo de carga NGINX distribuye las solicitudes entrantes entre múltiples servidores backend, evitando la sobrecarga de cualquier servidor individual. NGINX ofrece varios métodos de equilibrio de carga:

- Round Robin: Distribuye las solicitudes de manera secuencial entre los servidores disponibles

- Least Connections: Dirige el tráfico al servidor con menos conexiones activas

- IP Hash: Asegura que las solicitudes del mismo cliente siempre lleguen al mismo servidor

- Weighted: Asigna más tráfico a servidores con mayor capacidad de procesamiento

Para operadores de telecomunicaciones que manejan millones de conexiones simultáneas, esta capacidad de distribución inteligente es fundamental para mantener la calidad del servicio.

Terminación SSL/TLS centralizada

El proxy inverso puede manejar toda la encriptación SSL, liberando recursos valiosos en los servidores backend. Esta seguridad centralizada simplifica la gestión de certificados y reduce la carga computacional en los servidores de aplicación.

NGINX: La solución líder para Proxy inverso

El futuro de la infraestructura web pasa por arquitecturas distribuidas, seguras y eficientes, y el proxy inverso con NGINX es la piedra angular sobre la que construir estas soluciones. Ya sea que estés modernizando sistemas legacy, implementando nuevas aplicaciones cloud-native, o simplemente buscando mejorar la experiencia de tus usuarios, dominar la configuración y gestión de un proxy inverso te proporcionará las herramientas necesarias para enfrentar los desafíos tecnológicos actuales y futuros.

¿Qué es NGINX?

NGINX que es una pregunta común entre quienes buscan soluciones de servidor web y proxy inverso. NGINX es un servidor web de alto rendimiento y proxy inverso de código abierto, conocido por su eficiencia, estabilidad y bajo consumo de recursos. Desarrollado inicialmente para resolver el problema C10K (manejar 10,000 conexiones concurrentes), NGINX se ha convertido en el estándar de facto para implementaciones de proxy inverso en producción.

Ventajas de utilizar NGINX como Proxy inverso

El servidor web nginx ofrece importantes ventajas sobre otras soluciones:

Alto rendimiento y escalabilidad: NGINX puede manejar miles de conexiones simultáneas con un consumo mínimo de memoria, ideal para infraestructuras que requieren alta disponibilidad y rendimiento consistente.

Configuración flexible y modular: La arquitectura modular de NGINX permite personalizar exactamente las funcionalidades necesarias, desde simple proxy HTTP hasta complejas configuraciones de balanceo de carga y caché.

Compatibilidad con múltiples protocolos: NGINX maneja HTTP, HTTPS, TCP, UDP, SMTP, POP3 e IMAP, otorgando una solución unificada para diferentes necesidades de proxy.

Comunidad activa y soporte empresarial: Con una amplia comunidad de desarrolladores y opciones de soporte comercial, NGINX ofrece la confiabilidad que las empresas necesitan para sus operaciones críticas.

Cómo configurar NGINX como Proxy inverso para reenviar tráfico HTTP

Un Proxy Inverso NGINX actúa como un intermediario que recibe solicitudes de clientes y las reenvía a uno o más servidores internos (backend). Esto ayuda a mejorar la seguridad, el rendimiento y la distribución del tráfico.

Requisitos esenciales (prerrequisitos)

Antes de comenzar la configuración, es necesario contar con:

- Un servidor con Linux (como Ubuntu, CentOS o Debian).

- Acceso de administrador (root o sudo) al servidor.

- Tener el software NGINX instalado en el sistema.

- Un conocimiento básico de cómo usar la línea de comandos.

Instalación de NGINX

La instalación puede variar según la distribución de Linux que utilices.

- En sistemas basados en Debian/Ubuntu: Se debe actualizar primero la lista de paquetes del sistema y luego usar el gestor de paquetes para instalar NGINX. Una vez instalado, se debe iniciar el servicio y configurarlo para que se ejecute automáticamente cada vez que el servidor arranque.

- En sistemas basados en CentOS/RHEL: El proceso incluye la instalación de un repositorio de paquetes adicional (epel-release) antes de instalar NGINX con el gestor de paquetes. Finalmente, se inicia y se habilita el servicio de manera similar a Ubuntu.

Configuración básica del Proxy inverso

La configuración principal del proxy inverso se realiza modificando archivos de configuración de NGINX. Aunque el archivo principal es /etc/nginx/nginx.conf, se recomienda crear ajustes específicos en el directorio de sitios disponibles, típicamente en /etc/nginx/sites-available/.

Para una configuración básica, se crea un nuevo archivo. Dentro de este archivo se define un bloque de servidor (server) que escucha en el puerto ochenta (80), asociado al nombre de tu dominio.

Dentro de este bloque, una sección de ubicación (location /) indica que todo el tráfico debe ser reenviado (proxy_pass) a un servidor interno específico (por ejemplo, a una dirección y puerto como http://servidor-backend:8080).

Es crucial agregar encabezados (proxy_set_header) para que el servidor de backend sepa la dirección del cliente original, el nombre de host solicitado, y el protocolo utilizado, lo que permite que el backend funcione correctamente.

Configuración avanzada con balanceo de carga (load balancing)

Para distribuir el tráfico entre múltiples servidores backend y evitar que uno solo se sature, se utiliza el balanceo de carga.

- Definición de Upstream: Se define un grupo de servidores internos (upstream backend_servers). Es posible definir un método de balanceo, como el de menos conexiones activas (least_conn), para dirigir el tráfico al servidor menos ocupado

- Asignación de Peso y Respaldo: Se listan los servidores backend con sus direcciones. Se pueden asignar pesos (weight) para que unos reciban más tráfico que otros, e incluso designar un servidor como respaldo (backup) que solo se active si los demás fallan.

- Uso en el Bloque Server: En el bloque de servidor, la directiva proxy_pass se dirige ahora al nombre de este grupo upstream (http://backend_servers) en lugar de a un único servidor.

Adicionalmente, se pueden configurar los tiempos de espera (proxy_connect_timeout, proxy_send_timeout, proxy_read_timeout) para manejar la conexión entre el proxy y los servidores backend de forma más robusta.

Implementación de caché (caching)

Para mejorar el rendimiento, NGINX puede almacenar en caché las respuestas de los servidores backend.

- Definición de la Ruta de Caché: Se debe definir una ruta para el caché (proxy_cache_path), especificando dónde se guardarán los archivos, el tamaño máximo de la zona de claves (keys_zone), el tamaño máximo total del caché (max_size) y el tiempo de inactividad de los archivos antes de ser eliminados (inactive).

- Activación en el Bloque Location: En el bloque de ubicación, se activa el caché (proxy_cache) haciendo referencia a la zona definida. Se detallan los tiempos de validez (proxy_cache_valid) para las distintas respuestas HTTP (por ejemplo, diez minutos para respuestas correctas o un minuto para errores).

- También es posible configurar el uso de respuestas obsoletas (proxy_cache_use_stale) cuando se presentan errores o timeouts en el backend, asegurando que el cliente reciba contenido aunque no sea el más reciente.

Configuración de Seguridad SSL/TLS (HTTPS)

Para garantizar la seguridad de la comunicación, se recomienda habilitar el protocolo HTTPS (SSL/TLS).

- Escucha en el Puerto 443: El bloque de servidor debe escuchar en el puerto cuatrocientos cuarenta y tres (443) e incluir las directivas ssl y http2.

- Certificados: Se debe especificar la ruta de los archivos del certificado (ssl_certificate) y de la clave privada (ssl_certificate_key).

- Protocolos y Cifrados: Se configuran los protocolos de seguridad (ssl_protocols) y los cifrados (ssl_ciphers) modernos para asegurar una conexión fuerte.

- Encabezados de Seguridad: Se añaden encabezados de seguridad HTTP como Strict-Transport-Security (HSTS), X-Frame-Options y X-Content-Type-Options para mitigar varios tipos de ataques web.

- Reenvío: Finalmente, el reenvío al backend se mantiene, pero se añade un encabezado para informar que la conexión original del cliente fue HTTPS (X-Forwarded-Proto https).

Consideraciones de seguridad adicionales

El set-up del proxy inverso puede incluir capas de seguridad para proteger el backend.

- Protección contra Ataques DDoS (Limitación de Tasa): Se puede definir una zona de limitación de solicitudes (limit_req_zone) basada en la dirección IP del cliente, especificando la tasa máxima de peticiones por segundo. Luego, esta zona se aplica a las ubicaciones deseadas, permitiendo una ráfaga (burst) temporal de peticiones antes de aplicar el retraso o rechazo.

- Bloqueo de Métodos HTTP: Se pueden bloquear métodos de solicitud HTTP no deseados (como PUT o DELETE) que no sean necesarios.

- Bloqueo de Agentes de Usuario: Se pueden implementar reglas para rechazar (return 403) las peticiones de usuarios sospechosos, como bots y crawlers maliciosos.

- Límites de Tamaño: Se puede limitar el tamaño máximo de la solicitud de un cliente (client_max_body_size) para prevenir ataques de sobrecarga de datos.

- Monitoreo y Registro (Logging): Es esencial configurar registros (logs) detallados (log_format) que incluyan información crítica como la dirección IP del cliente, el tiempo de respuesta del servidor y el agente de usuario, para facilitar el análisis de seguridad y la resolución de problemas. Estos registros se guardan en archivos de acceso y error.

Usos del Proxy inverso según el sector

Sector telecomunicaciones

Para operadores como los clientes de Whitestack, el proxy inverso es fundamental en la implementación de redes 5G y la gestión de millones de conexiones simultáneas. La capacidad de distribuir carga entre múltiples servidores permite manejar el tráfico masivo de datos mientras se mantiene la latencia al mínimo.

Gobierno digital

¿Cuál es el estado de la transformación de los gobiernos digitales? Las instituciones gubernamentales utilizan proxy inverso para modernizar sus servicios digitales, proporcionando una capa de abstracción entre los ciudadanos y los sistemas legacy. Esto permite actualizar gradualmente la infraestructura backend sin interrumpir los servicios públicos.

Banca y finanzas

Los bancos implementan proxy inverso para cumplir con regulaciones estrictas de seguridad mientras compiten con fintechs ágiles. La terminación SSL centralizada y el filtrado de tráfico malicioso son esenciales para proteger transacciones financieras sensibles.

Retail

Las plataformas de e-commerce utilizan proxy inverso para manejar picos de tráfico durante eventos de venta, implementando caché agresivo para contenido estático y distribuyendo la carga de procesamiento de transacciones entre múltiples servidores.

Mejores prácticas y recomendaciones

Optimización de performance

- Ajuste de workers: Configurar el número de worker processes según los núcleos de CPU disponibles

- Compresión gzip: Habilitar compresión para reducir el ancho de banda

- Keep-alive connections: Mantener conexiones persistentes para reducir latencia

- Buffer tuning: Ajustar tamaños de buffer según el tipo de contenido servido

Mantenimiento y monitoreo

- Health checks regulares: Implementar verificaciones de salud para backends

- Rotación de logs: Configurar logrotate para gestionar el espacio en disco

- Métricas de performance: Usar herramientas como Prometheus para monitoreo continuo

- Backups de configuración: Mantener versiones de configuración en control de versiones

Escalabilidad

- Arquitectura distribuida: Implementar múltiples proxies inversos con balanceo DNS

- Auto-scaling: Integrar con plataformas cloud para escalado automático

- CDN integration: Combinar con CDN para contenido estático global

- Caching estratégico: Implementar múltiples niveles de caché según el tipo de contenido

Implementando NGINX para marcar la diferencia

El reverse proxy con NGINX representa una solución fundamental para organizaciones que buscan optimizar, asegurar y escalar su infraestructura web. Desde la protección contra ataques hasta la mejora del rendimiento mediante caché y balanceo de carga, las capacidades que ofrece son esenciales en el panorama digital actual.

La implementación correcta de un servidor proxy inverso puede marcar la diferencia entre una infraestructura que apenas sobrevive y una que prospera bajo demanda. Para empresas en sectores críticos como telecomunicaciones, gobierno, banca y retail, donde Whitestack proporciona soluciones de infraestructura digital, el proxy inverso no es solo una opción, sino una necesidad estratégica.